Der Nutzen von A/B-Testing, Split-Testing und multivariaten Tests

Wir alle kennen A/B-Tests: Sie sind eine nützliche Hilfe, wenn es darum geht, verschiedene Versionen eines Items miteinander zu vergleichen.

In Mautic gibt es umfangreiche A/B-Tests für E-Mails: Mit ihnen kann man E-Mail-Öffnungsraten und Klickraten sowie den Aufruf von Downloads und Formularen vergleichen.

Es gibt jedoch noch einen anderen relevanten und bei uns sehr beliebten Kanal, für den wir gerne A/B-Testoptionen hätten: Mautic Focus Items.

Die Fragestellung ist dort etwas komplexer als bei E-Mails: Während es im Grunde darum geht, „welche meiner Focus Item Varianten (Inhalt, Optik, Verhalten) schneiden am besten ab?", besteht das Problem darin, dass es für „am besten abschneiden" eine Vielzahl möglicher Kriterien gibt.

Wie zum Beispiel...

- Die Klickrate (für den Typ „Link") / Submissionsrate (für den Typ „Formular")

- Die Conversion Rate (für alle Conversion-Ziele, die definiert werden können)

- Quantitatives Verhalten nach Erscheinen des Focus Items (nachfolgende Verweildauer / nachfolgende Anzahl von Seitenaufrufen)

- Qualitatives Verhalten nach Erscheinen des Focus Items („Was macht der User als nächstes, nachdem ein Focus Item angezeigt wurde?")

- Die Qualität der Conversions (Demographie, darauf folgende Conversions, durchschnittliches Kaufvolumen / Lifetime Value / Opportunity Size, .....)

- Dazu kommt, dass man bei einigen dieser Kriterien nicht nur Focus Items untereinander vergleichen kann, sondern auch die Option „überhaupt kein Focus Item" in Betracht ziehen sollte – ein wichtiger Aspekt!

Außerdem muss man sicherstellen, dass man wirklich Äpfel mit Äpfeln vergleicht..... Beispiel: Bei einem Focus Item, das nach 30 Sekunden angezeigt wird, dürfen die Ergebnisse nur mit dem Verhalten jener Besucher verglichen werden, die 30 Sekunden oder länger auf der betreffenden Seite bleiben und kein Focus Item angezeigt bekommen haben.

Dieser Prozess ist knifflig, um es vorsichtig auszudrücken, und nicht in Mautic's aktuellen Tools erhalten. Dennoch ist er für uns so interessant, dass wir uns entschieden haben, eine hartverdrahtete A/B-Analyse zu erstellen, d.h. mit einigen Tricks und einigen fest programmierten Statistiken für den konkreten Fall. Ziel ist also, nicht nur Fragen für das jeweilige Projekt zu beantworten, sondern auch Erfahrungen zu sammeln, die Fälle zu verstehen und mit der Arbeit an einer generischen Lösung innerhalb von Mautic zu beginnen.

Implementierung: Selbstgebauter A/B Test für Mautic Focus Items

Hier sind die Details für den komplexesten Fall, dem Vergleich „Focus Item vs. kein Focus Item":

a) Wie man eine bestimmte Anzahl an Besuchern den verschiedenen Verhaltensgruppen zuordnet

Da es in Mautic keinen wirklichen Zufallsgenerator gibt, haben wir diese Herausforderung folgendermaßen bewältigt:

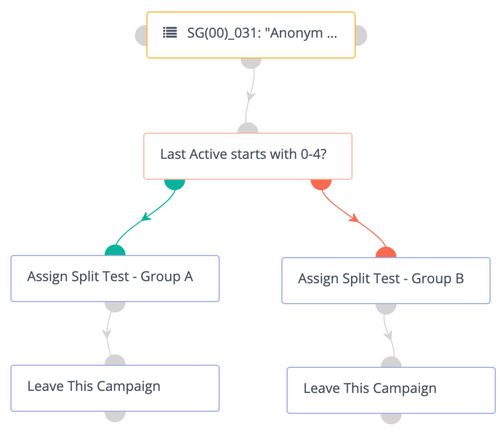

- Erstellen Sie ein Segment für jede Split-Test-Gruppe

- Erstellen Sie eine Kampagne, um jeden Kontakt in einem unserer Split-Test-Segmente zu platzieren, entsprechend der gewünschten Verteilung

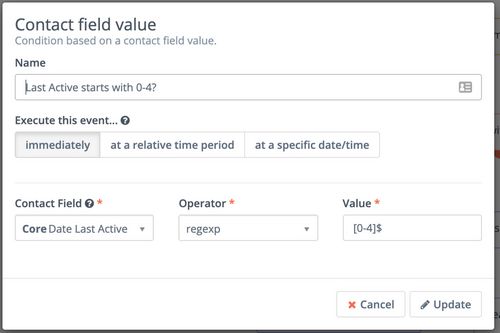

- Erstellen Sie innerhalb dieser Kampagne einen Wert namens „Kontaktfeld” als Bedingung, der die letzte Ziffer des „Date Last Active" des Kontakts betrachtet, welche gleichmäßig verteilt ist. Ein Regex "„0-4]$" gibt uns also zufällige 50%, und natürlich sind andere Splits auf diese Weise leicht möglich

- Bereitstellung von Focus Items durch Kampagnen, die das Split-Test-Segment des Kontakts berücksichtigen

Für unser Beispiel brauchen wir folgende Gruppen: „Gruppe A" = Focus Item, „Gruppe B" = kein Focus Item.

b) Arbeiten mit der Datenbank

Der andere Teil des Prozesses besteht darin, alle notwendigen Daten direkt aus der Datenbank abzurufen und diese Daten in die gewünschten Informationen umzuwandeln.

- Für jedes Focus Item (in unserem Fall: Kontakte in „Gruppe A", die mit dem betreffenden Focus Item geliefert wurden)

Aber auch für diejenigen Kontakte, die sich in „Gruppe B" befinden, d.h. das Focus Item gesehen hätten, wenn sie in einer anderen Splitgruppe wären. Was bedeutet das? Beispiel: Wenn das betreffende Focus Item auf „Anzeige nach 30 Sekunden" eingestellt ist, müssen wir feststellen, dass die Seitenaufrufe der Gruppe B zur gleichen Seitenzeit erfolgen, in der sich die Benutzer mindestens 30 Sekunden lang aufgehalten haben. - Und das alles für einen Zeitrahmen, der natürlich definiert werden muss.

Für diese Statistiken haben wir für unsere momentane Nutzung ein kleines PHP-Skript erstellt, das komplett außerhalb von Mautic läuft und CSVs liefert, mit denen man arbeiten kann.

Was sind die Erkenntnisse?

Wie bei den On-Page-Elementen von Mautic häufig der Fall, kann die Verzögerung zwischen Benutzerverhalten und Kampagnenaktion ein wenig lästig sein. Häufigere Cron-Jobs können die Situation verbessern (wo immer möglich), aber auch ein optimiertes Kampagnendesign hilft.

Wenn es um „Wie soll ein Mautic-interner A/B-Test aussehen" geht, ist es sinnvoll, eine längerfristige Vision im Hinterkopf zu haben (vielleicht inspiriert von spezialisierten Tools wie „Google Optimize", aber für den Anfang mit nur einem einfachen Vergleich und einer eher engen Definition von "bester Performance", d.h. Hypothese.)

Eine weitere sinnvolle Sache wäre, ein „unsichtbares" Focus Item zu haben, welches es uns ermöglicht, einen mit/ohne Vergleich auch für „getriggerte" Focus Items (Exit Intent, Scrollen,....) zu vereinfachen.

Außerdem sollte es natürlich im Allgemeinen mit dem Look & Feel von A/B-Tests in E-Mails übereinstimmen.

Klar: Die vorliegende Implementierung "manueller" A/B-Tests ist harte Arbeit und absolut nicht für jeden geeignet. Andererseits bekommen wir durch sie echte und wertvolle Resultate (statt Focus Items im Blindflug zu verwenden). Und zudem sammeln wir die nötige Erfahrung für eine künftige Implementierung innerhalb von Mautic.